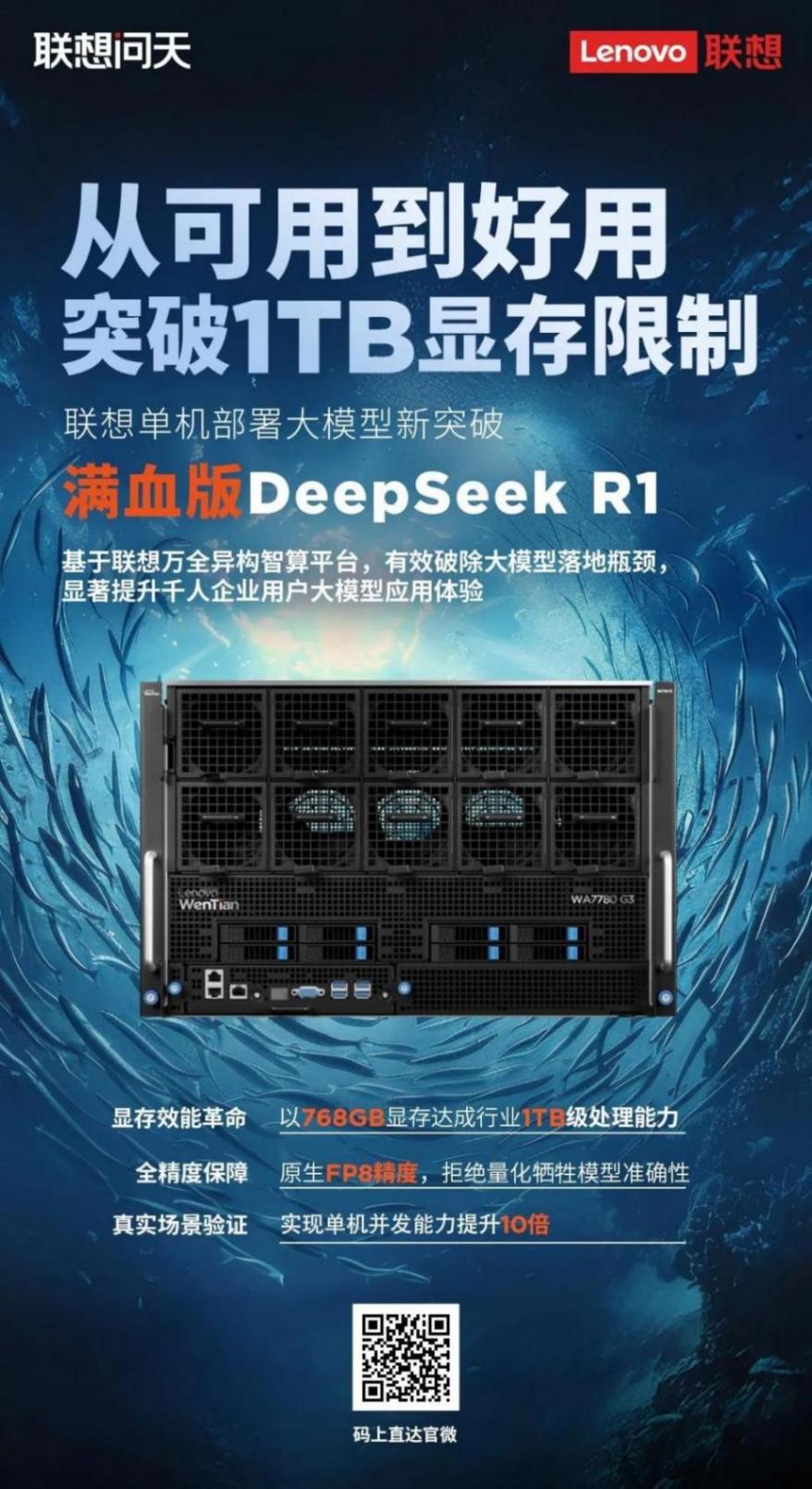

近日,聯想研究院智能計算基礎設施實驗室(ICI Lab)與聯想中國基礎設施業務群緊密協作,成功推出了一系列聯想問天DeepSeek推理一體機,實現了單機部署DeepSeek 671B滿血版大模型極限吞吐8268詞元/秒(token/s),千億參數大模型本地部署顯存需求低于1TB。

這一成果刷新了業界單臺服務器運行大模型性能的紀錄,為AI服務器大模型推理性能指標樹立了新的標桿,充分彰顯了聯想在AI智算基礎設施領域的深厚技術底蘊與領先實力。

此次突破性進展由聯想研究院智能計算基礎設施實驗室(ICI Lab)異構計算團隊攜手聯想中國基礎設施業務群,并聯合AMD共同設計實現。依托在智算基礎設施關鍵技術領域的持續積累,ICI Lab異構團隊針對DeepSeek大模型推理進行了全方位的技術創新與優化,涵蓋了高層編譯優化、集合通信優化以及分布式推理引擎優化等多個關鍵領域,極大提升了大模型的推理效率和性能。

高層編譯優化:深入分析負載特征和硬件架構,對MLA 和 GEMM kernel 算子性能進行了全面優化,顯著提高運算速度,從而加快模型的推理過程。同時,通過自適應混合精度量化在不同計算精度之間靈活切換,在保證模型精度的同時,節省了大量的算力和顯存資源,使得模型能夠在有限的硬件資源下高效運行,充分釋放硬件算力潛能。

集合通信優化: 自主研發的LCCL集合通信庫通過優化通信算法和數據傳輸策略,特別是針對分布式推理中的ALLReduce和ALLtoALL等關鍵操作進行了深度優化,有效減少了通信延遲和帶寬占用,提高了分布式推理的效率。

分布式推理引擎優化:單次生成多Token并行輸出,突破傳統序列解碼顯示,大幅提升了解碼階段的并行化水平。利用GPU/CPU協同推理機制通過動態調度算力負載,將GPU存算負載卸載至CPU,充分發揮異構算力效率。采用PD分離式推理架構將預填充與解碼階段分離,并分別適配不同硬件進行優化,滿足高并發大規模業務場景需求。