理工科 STEM 技能,是解決真實世界中諸多問題的基礎。譬如,探索蛋白質結構、證明數學定理、發現新藥物等。(編者注:STEM,即科學、技術、工程和數學四門學科英文首字母的縮寫。)

而對于人工智能領域來說,理解視覺-文本的多模態信息,則是掌握 STEM 技能的關鍵。

可是,現有的數據集主要集中在檢驗模型解決專家級別難題的能力上,難以反映模型在基礎知識方面的掌握情況。并且,其往往只考慮文本信息而忽略視覺信息,又或者只關注 STEM 中某單一學科的能力。

另外,由于缺少細粒度的信息,該領域的科學家也無法更好地分析與改進神經網絡模型存在的薄弱之處。

所以,模型在這種情況下生成的內容,既無法讓人充分信任,又不能幫助指導未來模型開發的方向。

更重要的是,由于缺乏和人類表現相關的數據,因此科學家也不可能獲取到更具實際意義的模型表現參考,嚴重阻礙了人工智能的健康發展。

為了攻克上述局限性,近期,來自北京大學和美國圣路易斯華盛頓大學的研究團隊,不僅成功完成了首個多模態 STEM 數據集的構建,還在此基礎上實現對大語言模型與多模態基礎模型的評測。

結果發現,即使是目前最先進的人工智能模型,其 STEM 基礎水平也存在較大的提升空間,尚不具備解決更有難度的現實問題的能力。也就是說,與人類智能相比,目前人工智能的水平還有一定差距。

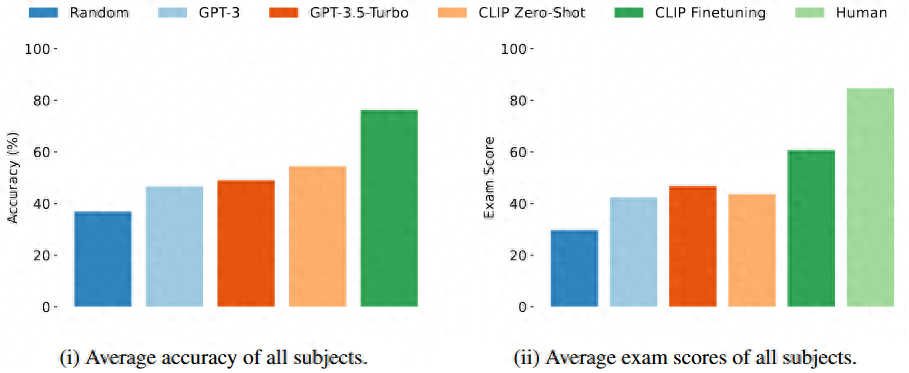

圖丨綜合評測效果(來源:ICLR 2024)

近日,相關論文以《測量神經網絡模型的視覺-語言理工科技能》(Measuring Vision-Language STEM Skills of Neural Models)為題收錄于 2024 國際表征學習大會(ICLR 2024,International Conference on Learning Representations 2024)上[1]。

據悉,該會議將于今年 5 月 7 日至 5 月 11 日在奧地利的首都維也納召開。

STEM 數據集相關資源如下。

評測鏈接:

https://huggingface.co/spaces/stemdataset/stem-leaderboard

數據集頁面:

https://huggingface.co/datasets/stemdataset/STEM

代碼 GitHub:

https://github.com/stemdataset/STEM

北京大學博士研究生沈劍豪和袁野是共同第一作者,圣路易斯華盛頓大學王晨光助理教授和北京大學張銘教授擔任共同通訊作者。王晨光助理教授博士畢業于北京大學,導師是張銘教授。

圖丨相關論文(來源:ICLR 2024)

搭建 STEM 數據集,全方位評測神經網絡模型的基礎理工科能力

據王晨光介紹,課題組在確定研究目標和題目之后,便開始著手收集數據。

一向擅長于算法研究的團隊成員,在面對爬蟲編寫、數據清洗和去重等工作時不免有些犯難。盡管如此,他們還是迎難而上,設計了多種用于數據清洗和去重的規則,最終成功獲得了首個多模態 STEM 數據集。

圖丨左起;王晨光、張銘、沈劍豪、袁野、Srbuhi Mirzoyan(來源:課題組)

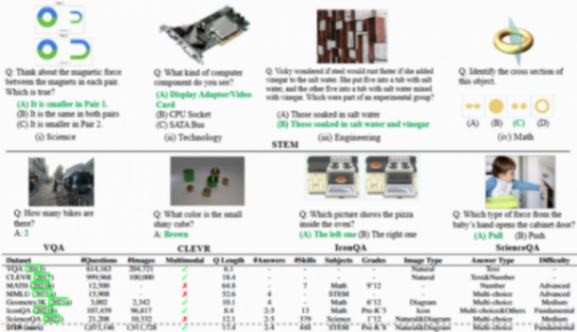

值得一提的是,該數據集包含 448 個 STEM 技能,共 1073146 道題目,是目前涵蓋面最廣、包含題目最多的多模態 STEM 題目數據集。

圖丨相關論文(來源:ICLR 2024)

接著,他們開始針對數據集進行評測與分析。

由于該數據集包含科目(科學、技術、工程、數學)、技能和年級三個維度標簽,因此研究人員選擇從這三個維度切入,對每個維度的數據數量分布、問題類型分布、問題長度分布等信息進行了詳盡分析。

與此同時,他們也針對每個科目,按照 6:2:2 的比例,劃分了訓練集、驗證集與未公開標簽的測試集。

隨后,研究人員又設計了模型評測方案。

其中,在選擇評測指標時,他們除了關注準確率,還重點使用全球范圍內最被認可的在線習題網站之一(https://www.ixl.com/)的考試分數。

后者是基于該網站千萬用戶的真實考試成績得出的,與學生對知識的掌握程度呈正相關。當分數達到 90 以上(通常是小學生水平)時,就代表學生掌握了該技能。

“我們讓模型模仿考生在線答題,再將得到的考試分數與真實人類的考試結果進行比較。”王晨光表示。

這也正是該工作的一大亮點。原因在于,過去將人類的表現與人工智能做比較時,前者都是由相對較小的樣本(例如幾百到幾千人)總結出的,而該團隊的結果卻是基于千萬量級的數據得到的,可信度更高。

然后,在模型評測環節,研究人員選擇使用當前主流的大基礎模型,包括 OpenAI 的多模態 CLIP 模型,以及大語言模型 ChatGPT 的 GPT3.5-Turbo 版本。

前者根據模型判斷問題選項與圖片的匹配程度來做出選擇,后者則利用字幕模型為圖片生成描述,并利用語言模型選擇回答。

“我們評測了不同規模的 CLIP 模型與 GPT3.5-Turbo 模型,發現在 0 樣本的設置下,模型的錯誤率很高。這表明現有模型無法直接真正地掌握這些知識。”王晨光表示。

進一步地,他們又利用劃分出的訓練數據集,對 CLIP 模型進行了微調,發現微調后的模型取得了顯著的效果提升,綜合準確率從 54.4% 提升至 76.3%。不過,這離 90 分依然有一定差距。

除此之外,該課題組還對模型結果的各個側面進行了分析。

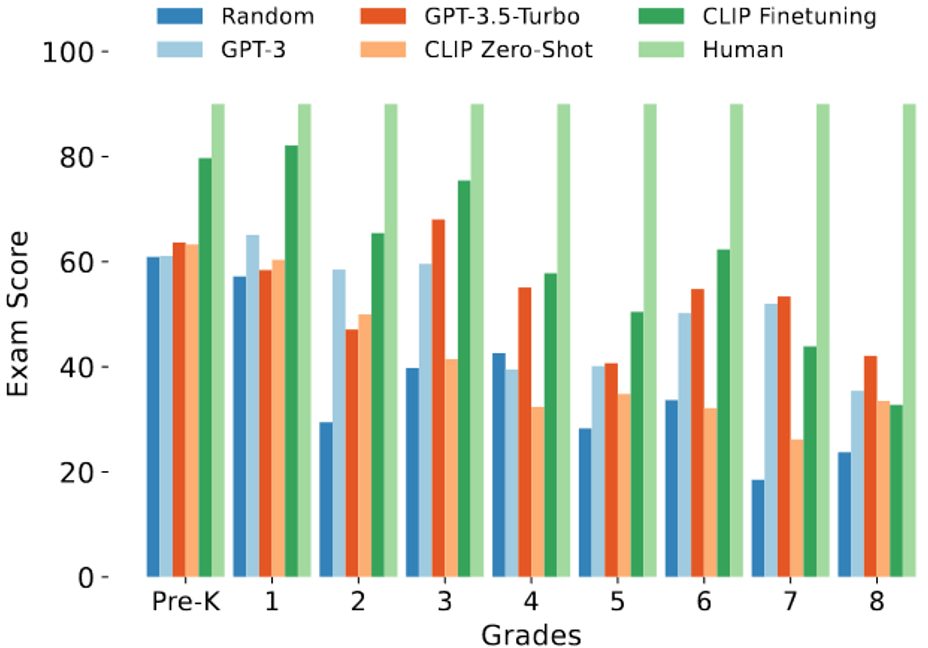

具體來說,首先,在年級層面,他們發現模型的測驗分數隨著題目所屬年級的升高而降低,這符合年級越高的題目難度就越高的預期。

圖丨測驗分數隨年級變化(來源:ICLR 2024)

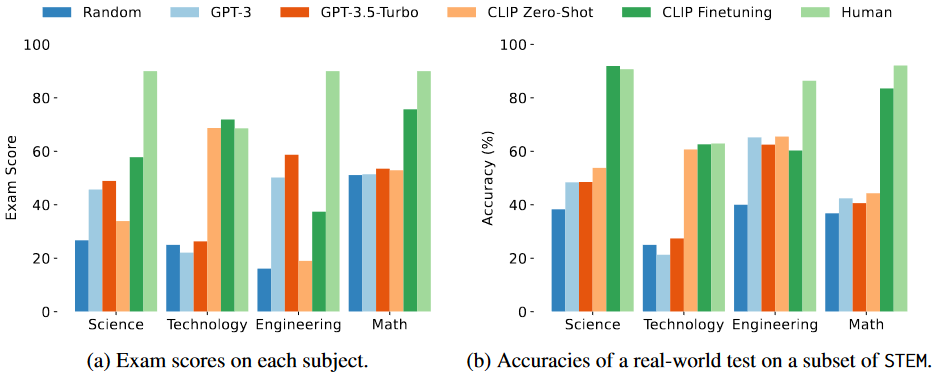

其次,通過模型在不同技能上的評測表現,他們發現模型在抽象知識與復雜推理任務上的表現欠佳。

另外,過去的經驗表明,模型應該對正確答案有著較高的預測置信度,這代表著模型的校準度較好。

“我們發現在我們的數據集上微調過的模型,表現出了良好的校準性,模型的置信度與準確率呈現清晰的相關性。”王晨光說。

另一方面,他們在研究模型規模與效果之間關系的過程中,也發現了清晰的正相關關系。

與此同時,他們還分析了模型表現與問題長度、問題類型、選項數量等其它因素之間的關系,發現隨著問題變長、選項數量變多和樣例數量變少,模型的表現都會下降。

除此之外,他們也評估了準確率與測驗考試分數這兩種指標的相關性,發現它們同樣呈現出顯著的正相關。

“最終,在整體的評價指標上,我們確認即使是微調過的模型,與人類對應年級學生水平相比也有顯著差距。基于此,我們仍然需要尋找更有效的方法,使模型掌握 STEM 知識技能。”王晨光說。

圖丨與人類表現比較(來源:ICLR 2024)

嘗試推出更多評測大語言模型的數據集,加快通用人工智能實現的進程

顯而易見,在該項研究中,STEM 數據集發揮了關鍵作用。

它不僅有利于模型增強 STEM 的基礎知識,還能幫助研究人員評估模型對于基礎 STEM 技能掌握的程度,并通過細粒度的數據分析有針對性地改進模型。

王晨光表示,他和團隊期待該數據集可以進一步推動當前多模態大模型的研究,朝著模型能夠充分理解 STEM 技能、解決真實場景下 STEM 問題的目標更進一步。

并且,也希望發布的測試集可以作為評測人工智能基礎模型能力的標準評測之一,得到社區的廣泛使用。

“更重要的是,我們提供的與大規模人類(主要是小學生)真實水平的比較,可以作為未來模型開發的目標和參考,以加快通用人工智能目標實現的進程。”他說。

目前,基于該數據集,該課題組已經成功評測了神經網絡模型在基礎教育中的理工科能力。

接下來,他們一方面計劃繼續收集數據,并嘗試推出諸如人文學科、社會學科等領域的數據集,以更好地評測大語言模型在其他關鍵學科上的能力。

在這方面值得關注的是,該團隊最近已經提出了一個新的社會學科數據集 Social,包含較大規模的文本評估數據,可用來評測大語言模型的社會學科基礎能力。

進一步地,還設計了一種多智能體交互的方法,能夠增強大語言模型在 Social 數據集上的表現。

相關論文以《衡量大語言模型的社會規范》(Measuring Social Norms of Large Language Models)為題收錄于計算語言學協會北美分會 2024 年年會(NAACL 2024,2024 Annual Conference of the North American Chapter of the Association for Computational Linguistics)上[2]。

據悉,該會議將于今年 6 月 16 日至 6 月 21 日在墨西哥的首都墨西哥城召開。

另一方面,他們也打算通過研究模型在細粒度數據集上的表現,找出模型能力不足的部分,并研究如何改進。

此外,還希望通過結合檢索的 RAG 方法、設計特殊的模型架構和訓練方法,來進一步增強模型的基礎能力。

“我們相信,只有先在基礎理工科和文科領域實現突破,扎實打好基礎,人工智能才有被進一步應用的可能性。”王晨光如是說。